Appearance

AI 工具与模型安装指南

1 整体说明

1.1 注意事项:

- 推荐使用常见 linux 系统比如 centos,Ubuntu

- Xinference 要求 cuda 版本不能低于 12.4

- 配置要求

模型名称 开发级 生产级 deepseek-r1:1.5B 普通 CPU 即可 - deepseek-r1:14B 4070ti-x1,显存 16G 4070ti-x2,显存 16G deepseek-r1:32B 不建议部署 A100-x2/H100-x2,显存 40Gx2

2 gpu 驱动安装

以使用 Ubuntu 系统为例

- 卸载原驱动

sudo apt purge "_nvidia_" - 下载安装驱动

sudo ubuntu-drivers install - 验证是否成功

nvidia-smi - 安装

cuda sudo apt install nvidia-cuda-toolkit,确认是否安装成功nvcc --version - 配置环境变量

sudo vim ~/.bashrc - 在文件末尾添加以下内容并保存,版本以

nvcc --version命令查看的版本为准,我这看到安装的是 12.0:

bash

export PATH=/usr/local/cuda-12.0/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda-12.0/lib64:$LD_LIBRARY_PATH3 1panel 安装指南

3.1 简介

1panel 是一个开源的应用容器管理平台,允许开发者将应用及其依赖打包成轻量级的容器并管理。 此应用在安装时会自带 docker 和 docker compse。

3.2 在线安装

- 执行命令

bash

curl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && sudo bash quick_start.sh- 按照操作步骤输入对应的端口和用户名密码

4 Ollama 安装与使用

4.1 简介

Ollama 是一个开源的大型语言模型(LLM)平台,让用户能够轻松地在本地运行、管理和与大型语言模型交互。

4.2 安装

- 进入 1panle 面板

- [AI-模型]下手动安装 ollama

- 无法正常安装时,修改容器的镜像加速地址

bash

"https://docker.1panelproxy.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.1panel.live",

"https://docker.nju.edu.cn",

"https://docker.m.daocloud.io",

"https://dockerproxy.com",

"https://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn",

"https://registry.docker-cn.com",

"https://registry.cn-hangzhou.aliyuncs.com",

"https://dockerhub.icu",

"https://hub.rat.dev",

"https://docker.wanpeng.top",

"https://doublezonline.cloud",

"https://docker.1ms.run",

"https://docker.xuanyuan.me",

"https://cr.laoyou.ip-ddns.com",

"https://docker-0.unsee.tech",

"https://dockerpull.cn",

"https://hub.fast360.xyz"4.3 常用命令

- 查看已安装的模型:

ollama list - 查看当前模型状态:

ollama ps - 删除已安装的模型:

ollama rm - 全部模型查看:https://ollama.com/library/deepseek-r1

4.4 在线安装

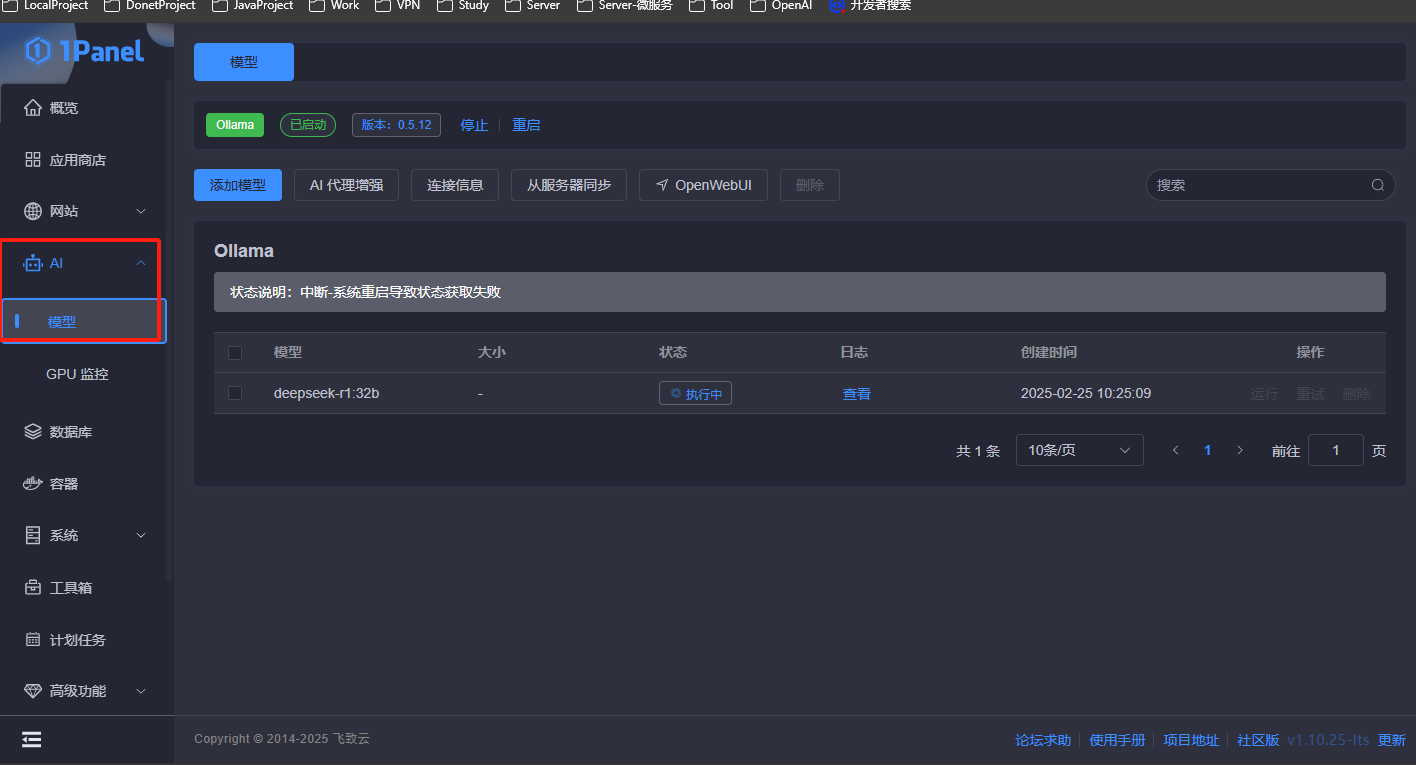

- 打开 1panel 的 [AI-模型]菜单

- 点击添加模型,手动输入对应的模型名称:

bash

deepseek-r1:1.5b

deepseek-r1:14b

deepseek-r1:32b

deepseek-r1:70b5 Xinference 安装与使用

5.1 简介

XInference 是一个性能强大且功能全面的分布式推理框架,支持大语言模型(LLM)、语音识别模型、多模态模型等多种模型的推理。

5.2 在线安装

bash

docker run -d --name xinference --gpus all -v /opt/xinference/models:/root/models -v /opt/xinference/.xinference:/root/.xinference -v /opt/xinference/.cache/huggingface:/root/.cache/huggingface -e XINFERENCE_HOME=/root/models -p 9997:9997 xprobe/xinference:latest xinference-local -H 0.0.0.05.3 校验

通过以下地址访问:http://localhost:9777

6 Dify 安装与使用

6.1 下载路径

\\\\10.10.1.30\\ftp\\AI\\soft\\dify

6.2 在线安装

- 将 dify 的 zip 文件复制到服务器的文件夹中。

- 使用

unzip dify.zip解压 dify.zip。 - 进入

cd dify/docker目录。 - 启动命令:

docker compose up -d - 关闭命令:

docker compose down - 使用以下地址访问:

http://localhost